2025 年我們看到廚了 OpenAI 之外後起之秀 DeepSeek 突然跳出檯面早成台積電與輝達股價突然劇烈震盪!! 聰明人應該都進場撿便宜了對吧!!! 回檔時就是賺錢的時機一點也沒錯!!

雖然我們可以透過 DeepSeek 的 API 與線上服務去體驗他的強大功能, 但是也因為樹大招風也就引來全世界的好奇, 不知是真的太熱門還是駭客攻擊, DeepSeek 就在不久前突然因為流量因素暫停了一陣子, 蝦米?!?!? 我才使用沒幾次而已, 現在就不給我體驗了是怎樣!! 不過別擔心, 現在就讓我們透過 Ollma 來在自家中建立起 DeepSeek 模型, 體驗一下離線 AI 的魔力吧!!!

內部 Local 端使用 AI 的優點

- 資料隱私: 所有資料都在自己的環境中, 並不會上傳到遠端 Server, 不用擔心資料外洩.

- 可調整模型特性: 因應你的個人環境可使用不同大小的模型與特性, 讓 AI 效能更符合需求

- 不用聯網: 是的, 因為是你的個人環境, 所以不需要聯網就能使用!!! 如果你有 UPS電源, 颱風天台電斷電時也可以有 AI 使用的.

- 最後當然就是吃到飽的概念囉, 自己的環境當然沒有像是你申請 API 使用 AI 一般需要先儲值付款再一使用次數口款等等的限制, 想問多少次, 問多久通通免費!!

本機安裝使用 DeepSeek 教學

Part 1. 安裝 Ollama, 請到 Ollama 官網( https://www.ollama.com/download/windows ) 選擇你的作業系統, 他會跳出對應的安裝方式, 進行下載並執行後即可安裝完成.

Part 2, 選擇你要使用的模型, 請到 Ollama 的 Library 資源列表 ( https://www.ollama.com/library ), 本次我們使用 deepseek-r1, 點進去之後你會看到如下的畫面, 請點選紅色箭頭的地方可以打開下拉選單!

這邊主要是要讓你選擇模型的大小, 模型的大小會影響的當然就是 AI 思考的複雜度與完整性, 請依照你的環境特性去選擇喔!!! 如果你有安裝獨立顯示卡的話, 相對來講對於 ram 的需求會比較小, 反而是顯卡的 VRAM 對於運算的影響較大. ( 參考資料: https://apxml.com/posts/gpu-requirements-deepseek-r1), 另外再選擇模型時也要考慮你的儲存空間大小, 因為當你執行時他就會透過網路進行模型的下載. 請視你的硬體規格來做微調.

Part 3, 執行所選擇的模型, 上一步你選定好模型的規模之後, 畫面上會顯示執行所需要的指令範本如下圖所示

紅色箭頭處就是所需要的指令, 當然你可以點藍色箭頭的地方進行指令的複製.

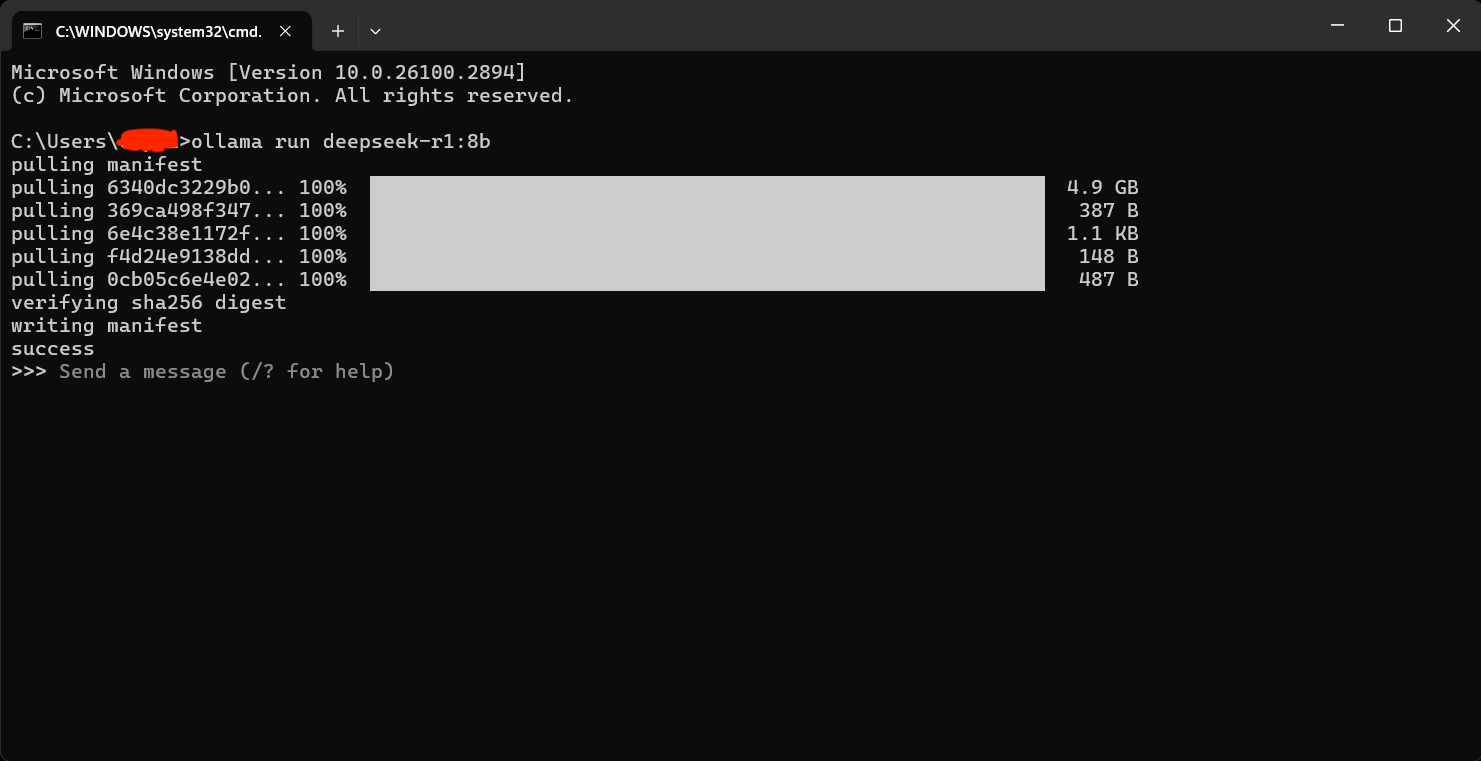

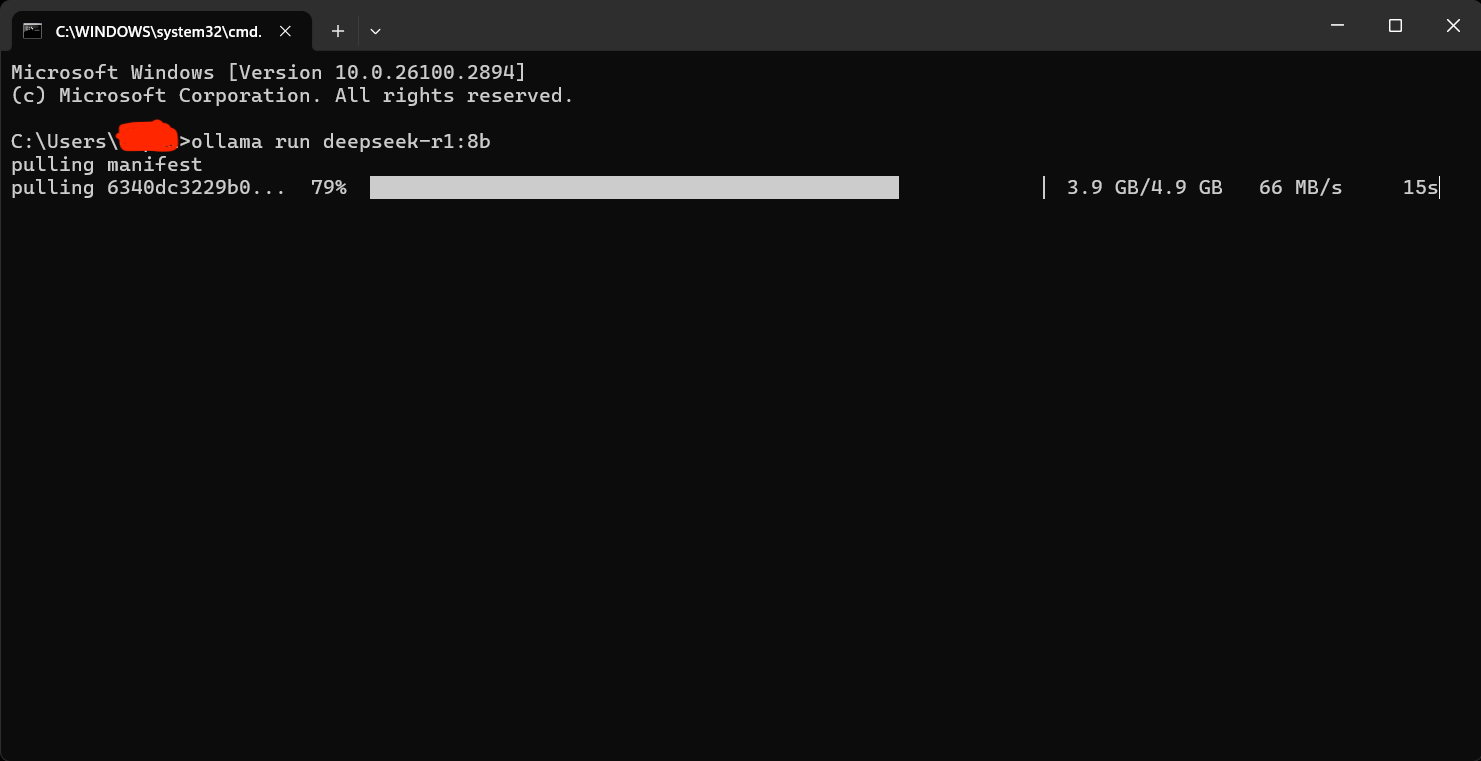

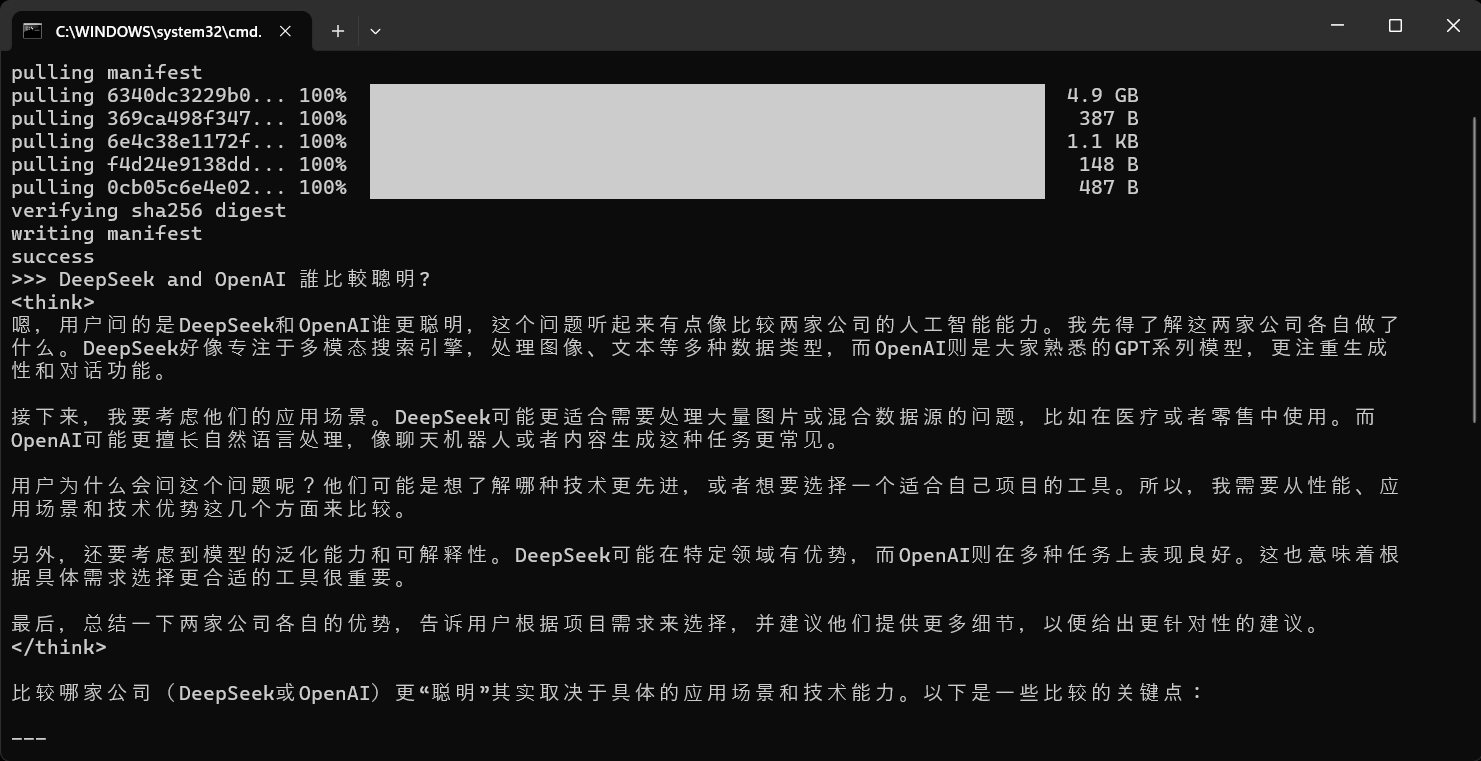

Part 4, 執行, 接下來我們回到終端機那邊輸入剛剛那段指令, 他就會開始進行下載, 過幾分鐘後看到 success 就表示下載完成, 畫面就會停留在互動模式, 你就可以在此與 AI 進行對話了喔!!! 以下我們用 Windows 環境當成範例 demo 給大家看.

<< 執行 ollama 取用 DeepSeek 模型 8b

<<開始進行下載模型的任務>>

<<看到 success 就代表完成, 可以開始與 AI 互動了>>

以上是不是很簡單, 不過當然目前也只是小小的利用離線版的 DeepSeek 做一點點小事情而已, 想要讓他發揮功能還有許多功能需要架設, 未來我們再利用 python 整合他來試試看喔!!! 敬請期待!!!